Künstliche Intelligenz (KI) ist im heutigen Geschäftsumfeld schnell zu einer wettbewerbsrelevanten Notwendigkeit geworden. Das Herzstück vieler KI-gestützter Lösungen sind Sprachmodelle, leistungsstarke Tools, die Text in menschlicher Sprache verarbeiten und erzeugen können. Diese Technologien verändern die Art und Weise, wie Unternehmen Dokumente und Daten verarbeiten sowie Entscheidungen treffen.

Der Erfolg jeder KI-Implementierung hängt jedoch von einem entscheidenden Faktor ab: der Qualität der Daten. Ohne fehlerfreie, gut strukturierte Daten können selbst die ausgefeiltesten Sprachmodelle scheitern. In diesem Leitfaden erläutern wir den Unterschied zwischen großen Sprachmodellen (LLMs) und kleinen Sprachmodellen (SLMs) und erklären, warum die Wahl des richtigen Modells zusammen mit hochwertigen Daten entscheidend ist, um das volle Potenzial von KI für Ihr Unternehmen zu erschließen.

Direkt zu:

Was ist ein kleines Sprachmodell?

Vorteile von kleinen Sprachmodellen

Beispiel für ein kleines Sprachmodell

Was ist ein großes Sprachmodell?

Vorteile von großen Sprachmodellen

Beispiel für ein großes Sprachmodell

Was ist ein Sprachmodell?

Ein Sprachmodell ist eine künstliche Intelligenz, die zur automatischen Erfassung, Erzeugung und Vorhersage von Text in menschlicher Sprache dient. Hierzu wird ein Sprachmodell mit umfangreichen Textdaten trainiert, an denen es die Grammatik, Muster und den Kontext von Wörtern und Sätzen erlernt. Das Modell nutzt dieses Wissen dann, um Sätze und Absätze zu schreiben, Fragen zu beantworten, Sprachen zu übersetzen und vieles mehr.

Was ist ein kleines Sprachmodell?

Ein kleines Sprachmodell (Small Language Model, SLM) ist – wie der Name schon sagt – ein Sprachmodell für kleinere Anwendungsbereiche. Diese KI-Tools sind so konzipiert, dass sie gezielt und effizient für die spezifischen Aufgaben eingesetzt werden können, für die sie entwickelt wurden.

SLMs sind in der Regel schneller, kostengünstiger und einfacher zu trainieren und damit ideal für konkrete, zielgerichtete Aufgaben. In Anwendungen wie der intelligenten Dokumentenverarbeitung (Intelligent Document Processing, IDP) können SLMs speziell entwickelt werden, um wichtige Funktionen wie Datenextraktion, Dokumentenklassifizierung, Texterkennung und Natural Language Processing (NLP) zu steuern. SLMs können Informationen aus einer Vielzahl von Dokumenttypen korrekt extrahieren, benötigen dabei weniger Rechenleistung und hinterlassen einen kleineren ökologischen Fußabdruck.

Was ist ein großes Sprachmodell?

Ein großes Sprachmodell (Large Language Model, LLM) ist eine künstliche Intelligenz, die in der Lage ist, in beeindruckender Qualität menschliche Sprache zu verstehen und für verschiedene Zwecke zu generieren. Diese Modelle können feine Nuancen erkennen und komplizierte Muster entschlüsseln und haben oft kreative, aufschlussreiche Antworten parat.

LLMs sind für ein breites Aufgabenspektrum geeignet. So könnte ein einziges LLM beispielsweise eine mehrsprachige Rechnung schreiben oder Gesundheitsdienstleister dabei unterstützen, klinische Notizen anzufertigen. Da LLMs mit Milliarden von Parametern arbeiten, benötigen sie mehr Rechenleistung – können diese Leistung jedoch nutzen, um einzigartige Inhalte zu erstellen, ausführliche Unterhaltungen zu führen und vieles mehr.

Vorteile von kleinen Sprachmodellen

Größer ist nicht immer besser. Kleine Sprachmodelle (SLMs) bieten eine Reihe von Vorteilen, die sie zur perfekten Wahl für bestimmte Geschäftsprozesse machen. Sehen wir uns fünf wichtige Vorteile an, die diese kompakten KI-Tools auszeichnen:

Schnelligkeit

Wenn Sie bestimmte Aufgaben in kürzester Zeit erledigen müssen, sind SLMs vielleicht die beste Wahl für Sie. Diese Werkzeuge benötigen zum Lernen nur eine relativ kleine Menge an Daten, die für ihre Aufgaben relevant sind. Dadurch sind SLMs leichter zu trainieren und arbeiten schneller – und das bei geringerer Umweltbelastung.

SLMs werden beispielsweise häufig in der intelligenten Dokumentenverarbeitung eingesetzt, um die Daten, die in den Eingangsdokumenten eines Unternehmens enthalten sind, schnell und genau zu identifizieren, zu klassifizieren und zu extrahieren. Zu den zahlreichen weiteren Anwendungen von SLMs zählen beispielsweise Chatbots zur Echtzeit-Kundenbetreuung und Echtzeit-Übersetzungsdienste, die ein laufendes Gespräch ermöglichen.

Budgetfreundlich

KI-Tools erfordern nicht immer einen hohen finanziellen Aufwand. SLMs lassen sich zum Beispiel kostengünstiger entwickeln und betreiben als LLMs. Selbst Start-ups können so von Anfang an KI-Leistungen kostengünstiger nutzen.

Anpassbar an die Bedürfnisse jeder Organisation

SLMs können auf die besonderen Verwendungszwecke jeder Organisation zugeschnitten werden, sei es zur Abwicklung rechtlicher Formalitäten oder zur Vereinbarung von Arztterminen. Diese Modelle können Sie mit Ihrem Fachwissen zu Experten auf Ihrem Gebiet ausbilden. Ein System muss ja nicht unbedingt für alle möglichen Anwendungen geeignet sein.

Genauigkeit

Wenn Sie exakte, zuverlässige Ergebnisse benötigen, sind SLMs oft die bessere Wahl. Da SLMs nur bestimmte Aufgaben beigebracht werden, können sie genauere Ergebnisse liefern als viel größere Modelle, und benötigen dafür nur einen Bruchteil der Bearbeitungszeit. Sie können innerhalb ihres Fachgebiets den Kontext nuancierter Fragen verstehen und individuelle, aussagekräftige und sachlich relevante Antworten geben. Tatsächlich ziehen immer mehr Unternehmen für ihre speziellen Anwendungen SLMs größeren, allgemeineren Modellen vor.

Leicht zu aktualisieren

Unternehmen müssen sich ständig an den Wandel der Zeit anpassen, entsprechend müssen sich auch ihre KI-Tools ändern. SLMs sind einfacher zu entwickeln und zu aktualisieren; sie lassen sich daher leichter mit den neuesten Informationen füttern und an aktuelle Branchentrends anpassen. So bleibt Ihr Modell aktuell und liefert Ihnen weiterhin wertvolle Informationen, während sich Ihr Unternehmen weiterentwickelt.

Vorteile von großen Sprachmodellen

Große Sprachmodelle (LLMs) werden mit großen Datenmengen trainiert. Sie können kreativ Texte erstellen, komplexe Fragen beantworten, den Kontext verstehen und Nuancen erkennen. LLMs können jedoch manchmal auch „halluzinieren“, das heißt Texte generieren, die zwar zunächst plausibel klingen, aber falsche oder unsinnige Informationen enthalten. Trotz dieser Einschränkung können LLM sowohl für Unternehmen als auch für Privatpersonen durchaus hilfreich sein.

Umfangreiche Wissensbasis

LLMs wurden mit einer Fülle von Informationen trainiert, sodass sie auf ein umfassendes Sprachverständnis und Allgemeinwissen zurückgreifen können. Diese Modelle können ein breites Spektrum von Fragen beantworten, Informationen vielerlei Art zusammenfassen und sogar eigenständig weitgehend fehlerfreie Inhalte erstellen.

Anpassbarkeit und Flexibilität

LLMs sind unglaublich vielseitig. Bekannte Allzweck-LLMs wie ChatGPT und Gemini können zudem für spezielle Geschäftszwecke vortrainiert werden. Sie können zum Beispiel an die Aufgabe angepasst werden, Informationen aus Papierdokumenten zu extrahieren oder Unternehmen zu unterstützen, mit den veränderlichen gesetzlichen Vorschriften Schritt zu halten. Unternehmen können LLMs so anpassen, dass sie eine Vielzahl branchenspezifischer Aufgaben erfüllen.

Mehrsprachige Fähigkeiten

Viele LLMs können Text in mehreren Sprachen verstehen und erzeugen. Diese Funktion ist besonders hilfreich, wenn Ihr Unternehmen in mehreren Ländern ansässig ist oder mit internationalen Lieferanten und Kunden zusammenarbeitet. Dies erleichtert die grenzüberschreitende Kommunikation und Zusammenarbeit.

Wissenssynthese

LLMs sind in der Lage, große Informationsmengen sinnvoll zu verarbeiten. Sie eignen sich daher besonders für Aufgaben, die ein tiefes Verständnis und eine detaillierte Analyse erfordern. So können LLMs beispielsweise tausende juristische Dokumente prüfen und ihre wesentlichen Inhalte zusammenfassen, sodass sich Juristen einen umfassenden Überblick verschaffen können, ohne jedes einzelne Dokument vollständig lesen zu müssen. Diese Fähigkeit, komplexe Informationen zu sammeln und miteinander zu verknüpfen, macht LLMs zu nützlichen Tools für gründliche Recherchen.

Gesteigerte Kreativität

LLMs sind aufgrund ihres umfassenden Trainings mit vielfältigen und umfassenden Sprachdaten, einschließlich verschiedener branchenspezifischer Terminologien und Kommunikationsstile, besonders versiert bei der Erstellung professioneller Inhalte. Die Qualität der Ergebnisse von LLMs hängt jedoch, insbesondere bei professioneller Nutzung, entscheidend von der Qualität ihrer Datenbasis ab. Mit den richtigen Daten und durch Nutzung externer Wissensquellen mittels RAG (Retrieval Augmented Generation) kann ein LLM überzeugende Marketingtexte verfassen, aufschlussreiche Berichte erstellen oder sogar personalisierte E-Mail-Antworten formulieren – und das alles unter Beibehaltung einer konsistenten Brand Voice. Mit ihren erweiterten Sprachressourcen können LLMs überzeugende und informative Inhalte produzieren und sind damit wertvolle Werkzeuge für die Geschäftskommunikation und die Erstellung von Inhalten.

SLMs im Vergleich zu LLMs: Was sind die Unterschiede?

Größe und Komplexität

Große Sprachmodelle (Large Language Models, LLMs) enthalten eine viel größere Menge an Wissen als kleine Sprachmodelle (Small Language Models, SLMs). Das liegt daran, dass LLMs mit einer enormen Anzahl von Parametern arbeiten, die oft im dreistelligen Millionenbereich liegt. Dadurch sind sie sehr leistungsfähig und in der Lage, ein breites Spektrum von Aufgaben zu bewältigen.

LLMs können jedoch auch langsam und ressourcenintensiv sein, da sie im Vergleich zu kleineren Modellen bis zu 50 Mal länger brauchen, um Informationen zu verarbeiten. Im Gegensatz dazu sind SLMs für bestimmte Zwecke konzipiert und kommen mit 1 bis 10 Millionen Parametern aus. Dadurch lassen sich SLMs schneller und effizienter trainieren und nutzen.

Kosten und Ressourcenbedarf

SLMs sind mit effizienten Kleinwagen vergleichbar, LLMs eher mit großen Lastwagen. Da LLMs viel mehr Rechenleistung und Speicherplatz benötigen, können sie recht teuer sein. LLMs können aufgrund ihres hohen Energieverbrauchs auch erhebliche Umweltauswirkungen haben. SLMs sind nicht so anspruchsvoll; sie verbrauchen weniger Energie und können oft auf Standardhardware ausgeführt werden.

Funktionalitäten

LLMs bewältigen ein breites Aufgabenspektrum und liefern in flüssiger Sprache korrekte Ergebnisse. Dagegen sind SLMs auf bestimmte Anwendungen spezialisiert, wodurch sie mit weniger Ressourcen und zu niedrigeren Kosten gute Leistungen erbringen können.

Ein kleines Sprachmodell, das auf die Rechnungsverarbeitung zugeschnitten ist, erfasst beispielsweise genau die Informationen, die Ihr Team benötigt, und ignoriert die irrelevanten Daten. Dieser fokussierte Ansatz beschleunigt nicht nur die Verarbeitung, sondern gewährleistet auch oft eine Genauigkeit, die mit der von viel größeren Modellen vergleichbar ist, und das bei geringerer Beanspruchung Ihrer Ressourcen.

Beispiele für LLMs und SLMs

Beispiel für ein kleines Sprachmodell

SLMs verändern mit ihrer anwendungsspezifischen Expertise und Effizienz ganze Branchen. Ein SLM, das auf die intelligente Dokumentenverarbeitung (IDP) zugeschnitten ist, kann beispielsweise die Texterkennung (OCR) bei der Dokumentenverarbeitung verbessern. Dies beschleunigt nicht nur den Arbeitsablauf, sondern verringert auch die Fehlerquote im Vergleich zu manuellen Methoden.

Beispiel für ein großes Sprachmodell

LLMs sind die treibende Kraft hinter beliebten KI-Tools wie ChatGPT, die eine breite Palette von Aufgaben bewältigen können, von der Ideenfindung über Werbekampagnen bis zur Übersetzung von Formularen. Allerdings können LLMs auch durch Training mit Milliarden von Parametern, die sich genau auf eine bestimmte Aufgabe beziehen, fein abgestimmt werden. Im Bereich Medizin könnte ein LLM beispielsweise mit einem riesigen Datenbestand aus medizinischer Literatur und Patientenakten dafür trainiert werden, komplexe medizinische Fragen zu beantworten.

RAG für LLMs & SLMs

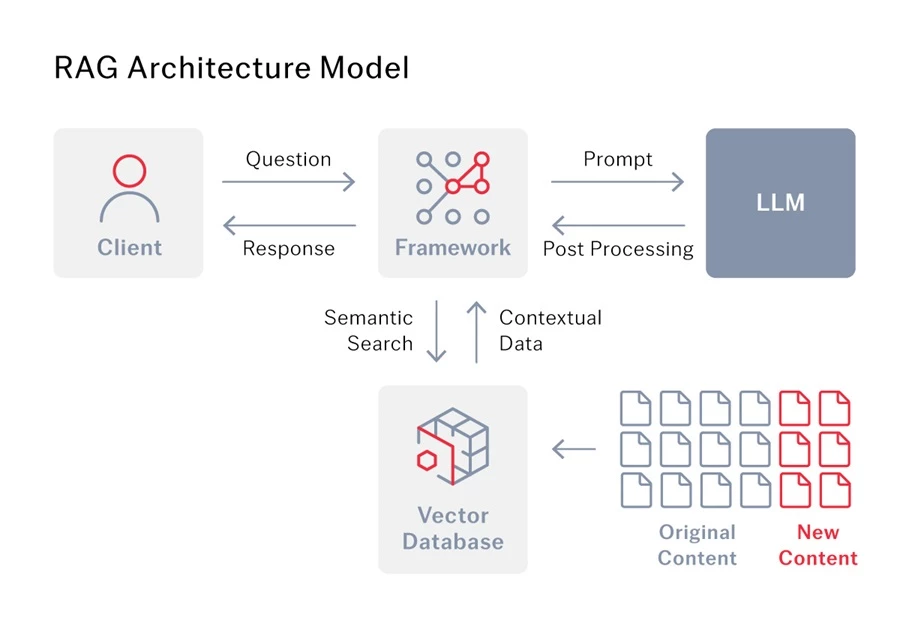

Was versteht man unter Retrieval Augmented Generation (RAG)?

Retrieval Augmented Generation (RAG) ist eine fortschrittliche KI-Methode, die es Sprachmodellen ermöglicht, bessere Antworten zu geben. Normalerweise können sich Sprachmodelle nur auf die Informationen stützen, mit denen sie trainiert worden sind. Aber mit RAG erhält das Modell auch Zugang zu einer separaten Wissensbasis oder Datenbank und kann diese zusätzlichen Informationen nutzen, um genauere Antworten zu generieren.

RAG für LLMs

LLMs sind großartig im Verfassen von Texten, aber ihr Wissen kann veralten. Retrieval Augmented Generation (RAG) löst dieses Problem, indem es LLMs mit externen Informationsquellen, wie dem Internet oder spezialisierten Datenbanken, verbindet, sodass sie immer auf die neuesten und relevantesten Fakten zugreifen können, um Ihre Fragen zu beantworten.

RAG verbessert aber nicht nur die Genauigkeit. RAG ordnet die gefundenen Informationen in den Kontext Ihrer Frage ein und hilft so dem LLM, besser zu verstehen, was Sie wissen wollen. Das Modell gibt dann differenziertere, treffendere Antworten mit geringerer Wahrscheinlichkeit von Halluzinationen. Hierfür sind qualitativ hochwertige Daten entscheidend, die den tieferen Kontext liefern, den das LLM braucht, um wirklich aufschlussreiche Antworten zu geben.

Nehmen wir als Beispiel Intelligent Document Processing (IDP). Wenn ein Unternehmen IDP zusammen mit einem LLM einsetzt, fungiert RAG als Bindeglied zwischen beiden. Im Wesentlichen stellt RAG dem LLM die beim IDP extrahierten Daten zur Verfügung, die es für präzisere Ergebnisse benötigt.

Die Wahl des richtigen Sprachmodells für Ihre Bedürfnisse

Die Wahl des richtigen Sprachmodells hängt vom Verwendungszweck ab. LLMs sind ideal für Aufgaben, die umfangreichen Kontext erfordern, während SLMs besser für spezifische, fokussierte Aufgaben geeignet sind und oft in größere Plattformen integriert werden, um dort Spezialaufgaben effizient auszuführen.

Möglicherweise verwenden Sie bereits SLMs in den Tools, mit denen Sie arbeiten. Die IDP-Plattform von ABBYY beispielsweise nutzt SLMs für Aufgaben wie OCR zusammen mit anderen KI-Technologien wie maschinelles Lernen und semantische Segmentierung. Diese Tools arbeiten zusammen, um Prozesse zu automatisieren, die Genauigkeit zu verbessern und damit Ihre Workflows effizienter zu gestalten.

Kombination von LLMs und SLMs

Ashling, ein preisgekröntes Unternehmen für intelligente Automatisierungsdienste, benötigte eine Lösung, um ihre Kunden bei der Extraktion von mehr als 350 Feldern aus Leasing-Dokumenten zu unterstützen, die sich in Qualität, Typ, Sprache und Format unterscheiden. Um diese Herausforderung zu lösen, testete Ashling mehrere Technologiekombinationen mit fünf verschiedenen Ansätzen und entschied sich für die Kombination, die ein deutlich besseres Ergebnis lieferte: LLMs und SLMs in Form von ABBYY Vantage und GPT-4 Turbo, zusammen mit der robotergestützten Prozessautomatisierung von Blue Prism.

Mit GPT4 und ABBYY Vantage wurde ein konsolidiertes Benutzererlebnis geschaffen, das schon vor dem Training auf Feldebene Ergebnisse liefert. Dieser Ansatz nutzt IDP für die Klassifizierung und Segmentierung und generative KI (GenAI) für die Feldextraktion. Durch die Integration von generativer KI, IDP und RPA zur Automatisierung der Datenextraktion und -eingabe wurde ein Genauigkeitsgrad von 82 % erreicht. Für die wenigen Felder, die jenseits der konfigurierten Konfidenzschwelle liegen, wird die manuelle Überprüfungsstation von ABBYY Vantage verwendet. Damit können menschliche Benutzer maschinell extrahierte Werte korrigieren. Das maschinelle Lernmodell lernt aus den von Menschen korrigierten Werten und verbessert sich mit der Zeit, sodass weniger manuelle Überprüfungen erforderlich sind. Lesen Sie hier die vollständige Fallstudie zu Ashling.

Die Qualität der Daten ist entscheidend

Wie präzise und zuverlässig die Ergebnisse sein werden, hängt letztlich von der Qualität der Daten ab, die Sie in das von Ihnen verwendete Sprachmodell einspeisen. Um Ihre Daten effektiv mit dem von Ihnen gewählten Sprachmodell zu verbinden, ist RAG unerlässlich. Retrieval Augmented Generation von ABBYY arbeitet nahtlos mit Sprachmodellen zusammen, um genaue, kontextbezogene und aktuelle Antworten zu liefern. Durch die Integration mit Ihrer bestehenden Wissensdatenbank stellt ABBYYs RAG Ihrer KI den Kontext bereit, den sie benötigt, um intelligente und zuverlässige Antworten zu generieren.

Setzen Sie sich mit einem unserer Experten in Verbindung und erfahren Sie, wie Ihr Sprachmodell Ihnen mit ABBYY schneller relevante und für Ihr Geschäft nützliche Antworten liefern kann.