Aujourd’hui, dans le monde des affaires, l'intelligence artificielle (IA) est rapidement devenue une nécessité pour rester compétitif. Au cœur de nombreuses solutions basées sur l'IA se trouvent les modèles de langage, de puissants outils capables de traiter et de générer du texte à la façon des humains. Ces technologies transforment la façon dont les entreprises gèrent les documents, les données et la prise de décision.

Cependant, la réussite de toute mise en œuvre de l'IA repose sur un facteur essentiel : la qualité des données. Sans données précises et bien structurées, même les modèles de langage les plus sophistiqués peuvent échouer. Dans ce guide, nous expliquerons la différence entre les grands modèles de langage (LLM) et les petits modèles de langage (SLM), et pourquoi le choix du bon modèle, associé à des données de grande qualité, est essentiel pour exploiter pleinement le potentiel de l'IA dans votre entreprise.

Passer à :

Qu'est-ce qu'un modèle de langage ?

Qu'est-ce qu'un petit modèle de langage ?

Avantages des petits modèles de langage

Exemples de petits modèles de langage

Qu'est-ce qu'un grand modèle de langage ?

Avantages des grands modèles de langage

Exemples de grands modèles de langage

Qu'est-ce qu'un modèle de langage ?

Un modèle de langage est un type d'IA développé pour comprendre, créer et prédire le langage humain. Pour simplifier, disons qu’un modèle de langage « apprend » en étant alimenté par de grandes quantités de texte, dont il extrait la grammaire, les structures et le contexte des mots et des expressions. Le modèle utilise ensuite ces connaissances pour écrire des phrases et des paragraphes, répondre à des questions, traduire des langues, etc.

Qu'est-ce qu'un petit modèle de langage ?

Un petit modèle de langage (SLM) est, comme son nom permet de le comprendre, un modèle de langage fonctionnant à petite échelle. Ces outils d'IA sont conçus pour se concentrer et être efficaces sur les tâches spécifiques pour lesquelles ils ont été conçus.

Les SLM sont généralement plus rapides, plus abordables et plus faciles à entraîner, ce qui les rend idéals pour des tâches spécifiques et ciblées. Dans des applications comme le traitement intelligent des documents (IDP), les SLM peuvent être spécialement conçus pour piloter des fonctions essentielles telles que l'extraction de données à partir de documents, la classification des documents, la reconnaissance optique de caractères (OCR) et le traitement du langage naturel (NLP). Les SLM peuvent extraire avec précision des informations d'un large éventail de types de documents tout en utilisant moins de puissance informatique et en ayant une empreinte environnementale réduite.

Qu'est-ce qu'un grand modèle de langage ?

Un grand modèle de langage (LLM) est une IA capable de comprendre et de générer le langage humain à un niveau de précision impressionnant pour diverses utilisations. Nuances subtiles, schémas complexes : ces modèles peuvent saisir ces détails infimes et proposer des réponses souvent créatives et instructives.

Les LLM sont capables d'effectuer une grande variété de tâches. Un seul LLM, par exemple, peut servir à rédiger une facture multilingue, ou même à aider à la rédaction de notes cliniques pour les professionnels de santé. Étant donné que les LLM sont développés avec des milliards de paramètres, ils nécessitent une puissance informatique plus importante, mais ils peuvent exploiter cette puissance pour créer du contenu unique, reproduire des conversations détaillées, et bien plus encore.

Avantages des petits modèles de langage

Plus grand n'est pas toujours synonyme de meilleur. Les petits modèles de langage (SLM) offrent de nombreux avantages qui en font le choix idéal pour certains processus métier. Penchons-nous sur cinq avantages clés qui distinguent ces outils d'IA compacts :

Performances rapides

Si vous avez besoin d’effectuer certaines tâches spécifiques en un clin d'œil, les SLM peuvent être la meilleure option pour vous. Ces outils apprennent à partir d'un ensemble de données plus restreint et plus ciblé, directement pertinent pour les tâches qu'ils sont censés effectuer. Ainsi, les SLM apprennent plus facilement et sont plus rapidement opérationnels, avec un impact environnemental réduit.

Par exemple, les SLM sont souvent utilisés dans l’IDP pour identifier, trier et extraire rapidement et précisément les données des documents entrants dans une entreprise. Parmi les autres utilisations des SLM, on peut citer les chatbots qui offrent un service client instantané et les services de traduction en temps réel qui fluidifient les conversations, pour n'en citer que deux.

Économique

Les outils d'IA ne nécessitent pas toujours des ressources financières importantes. Les SLM, par exemple, sont plus économiques à développer et coûtent moins cher à exploiter que les modèles de langage plus grands. Même les startups qui débutent ont la possibilité d'exploiter la puissance de l'IA à moindre coût.

Adapté à des organisations spécifiques

Chaque organisation a des besoins différents, et les SLM peuvent être conçus sur mesure pour y répondre, qu'il s'agisse de formulaires juridiques ou de rendez-vous médicaux. Ces modèles peuvent être formés à vos informations spécialisées pour devenir des experts dans votre domaine. Il n'est pas nécessaire d'avoir une solution universelle.

Précision

Lorsque vous avez besoin de résultats précis et fiables, les SLM constituent souvent la meilleure option. Les SLM étant formés à des tâches spécifiques, ils peuvent être plus précis que des modèles beaucoup plus grands, et avec un temps de traitement bien plus court. Les SLM peuvent comprendre le contexte de questions nuancées et générer des réponses uniques, pertinentes et significatives dans leurs domaines d'expertise. Pour répondre à leurs besoins spécifiques, de plus en plus d'entreprises optent d'ailleurs pour les SLM plutôt que pour des modèles plus grands et plus génériques.

Facile à mettre à jour

Les entreprises doivent constamment s'adapter aux changements. Vos outils d'IA doivent donc pouvoir s'adapter eux aussi à ces évolutions. Les SLM sont plus faciles à développer et à mettre à jour, ce qui signifie que vous pouvez plus facilement les maintenir à jour, en les alimentant avec les dernières informations et tendances du secteur. Votre modèle peut rester pertinent et continuer à fournir des informations précieuses, même à mesure que votre entreprise évolue.

Avantages des grands modèles de langage

Entraînés sur d'énormes quantités de données, les grands modèles de langage (LLM) peuvent générer des textes créatifs, répondre à des questions complexes et comprendre le contexte et les nuances. Cependant, les LLM peuvent aussi parfois « halluciner », générant des informations apparemment plausibles, mais incorrectes ou absurdes. Malgré ces limites, les atouts potentiels des LLM peuvent en faire un outil puissant pour les entreprises comme pour les particuliers.

Immense base de connaissances

Les LLM ont appris à partir d'une montagne d'informations, ce qui leur confère une compréhension approfondie du langage et du monde. Ces modèles sont capables de répondre à un large éventail de questions, de synthétiser de nombreux types d'informations et même de produire du contenu créatif avec une précision remarquable.

Adaptabilité et flexibilité

Les LLM sont incroyablement polyvalents. En même temps, les LLM en open source à usage générique, comme ChatGPT et Gemini parmi les plus connus, peuvent aussi être personnalisés et pré-entraînés pour des besoins professionnels spécifiques. Par exemple, les LLM peuvent être affinés pour extraire des informations de documents administratifs ou aider les entreprises à se tenir au courant des évolutions réglementaires gouvernementales. Les entreprises peuvent également personnaliser leurs LLM pour effectuer diverses opérations propres à leur secteur d’activité.

Capacités multilingues

De nombreux LLM peuvent comprendre et générer des textes en plusieurs langues. Cette fonctionnalité est particulièrement utile si votre entreprise est implantée dans plusieurs pays ou travaille avec des fournisseurs et des clients internationaux. La communication et la collaboration transfrontalières sont facilitées.

Synthèse des connaissances

Les LLM sont capables de traiter et d'interpréter de grandes quantités d'informations, ce qui est utile pour les tâches nécessitant une compréhension approfondie et une analyse minutieuse. Par exemple, les LLM peuvent examiner des milliers de documents juridiques et en résumer les points clés, permettant ainsi aux avocats d'obtenir une vue d'ensemble exhaustive sans avoir à lire chaque document dans son intégralité. Cette capacité à collecter et à relier des informations complexes rend les LLM utiles pour des recherches approfondies.

Créativité accrue

Les LLM sont particulièrement compétents dans la création de contenu professionnel grâce à leur formation approfondie sur des données linguistiques variées et complètes, incluant une terminologie et des styles de communication spécifiques à de nombreux secteurs d’activité. Mais il faut impérativement disposer de données de qualité pour obtenir de bons résultats avec les LLM, surtout dans un contexte professionnel. S’il dispose de données pertinentes et d’un RAG (génération augmentée de récupération) permettant de connecter les LLM à des sources de connaissances externes, un LLM peut rédiger des textes marketing percutants, générer des rapports pertinents ou même générer des réponses personnalisées aux emails, le tout en respectant l’image de la marque. Leurs capacités linguistiques de pointe permettent aux LLM de produire des résultats convaincants et informatifs, ce qui en fait des outils précieux pour la communication d'entreprise et la création de contenu.

Différences entre grands et petits modèles de langage

Taille et complexité

Les grands modèles de langage (LLM) contiennent un volume de connaissances bien plus important que les petits modèles (SLM). En effet, les LLM comportent un grand nombre de paramètres – souvent de plusieurs centaines de millions –, ce qui les rend très pointus et capables de traiter un large spectre de tâches.

Mais les LLM peuvent aussi être lents et gourmands en ressources, leur temps de traitement des informations pouvant être 50 fois plus élevé que celui des modèles plus petits. À l’inverse, les SLM sont conçus pour être plus rationalisés, avec un nombre de paramètres compris entre 1 et 10 millions. Cela rend les SLM plus rapides et plus efficaces à entraîner et à utiliser.

Exigences en termes de coûts et de ressources

Les SLM fonctionnent comme des voitures compactes et performantes, tandis que les LLM se comportent davantage comme de gros camions. Comme les LLM nécessitent beaucoup plus de puissance de calcul et de mémoire, leur exploitation peut être coûteuse. Leur forte consommation énergétique peut également engendrer de forts impacts environnementaux. Les SLM, en revanche, sont plus légers, consomment moins d'énergie et peuvent souvent fonctionner sur du matériel standard.

Fonctionnalités

Les LLM excellent dans un large éventail de tâches, fournissant des résultats précis et fluides. À l'inverse, les SLM sont spécialisés pour des applications spécifiques, ce qui leur permet d'être performants tout en utilisant moins de ressources et en réduisant les coûts.

Par exemple, un SLM développé pour la comptabilité fournisseurs peut se concentrer sur les informations exactes dont votre équipe comptable a besoin, ignorant toutes les autres données non pertinentes. Cette approche ciblée accélère non seulement le traitement, mais offre également souvent une précision comparable à celle de modèles beaucoup plus grands, tout en limitant la consommation de vos ressources.

LLM et SLM : exemples

Exemples de petits modèles de langage

Les SLM transforment des secteurs d’activité entiers grâce à leur expertise et leur efficacité ciblées. Un LLM conçu pour le traitement intelligent des documents (IDP), par exemple, peut améliorer la reconnaissance optique de caractères (OCR) lors du traitement des documents. Non seulement cela accélère le flux de travail, mais cela réduit également les erreurs par rapport aux méthodes manuelles.

Exemples de grands modèles de langage

Les LLM sont la force vive des outils d'IA populaires comme ChatGPT, capables de gérer une large gamme de tâches, allant du brainstorming de campagnes publicitaires à la traduction de formulaires. Cela dit, les LLM peuvent également être affinés par l'apprentissage sur des milliards de paramètres se rapportant précisément à une tâche spécifique. Par exemple, dans le domaine médical, un LLM pourrait être affiné sur un vaste ensemble de données de littérature médicale et de dossiers de patients afin de devenir un spécialiste des réponses à des questions médicales complexes.

RAG avec les LLM et les SLM

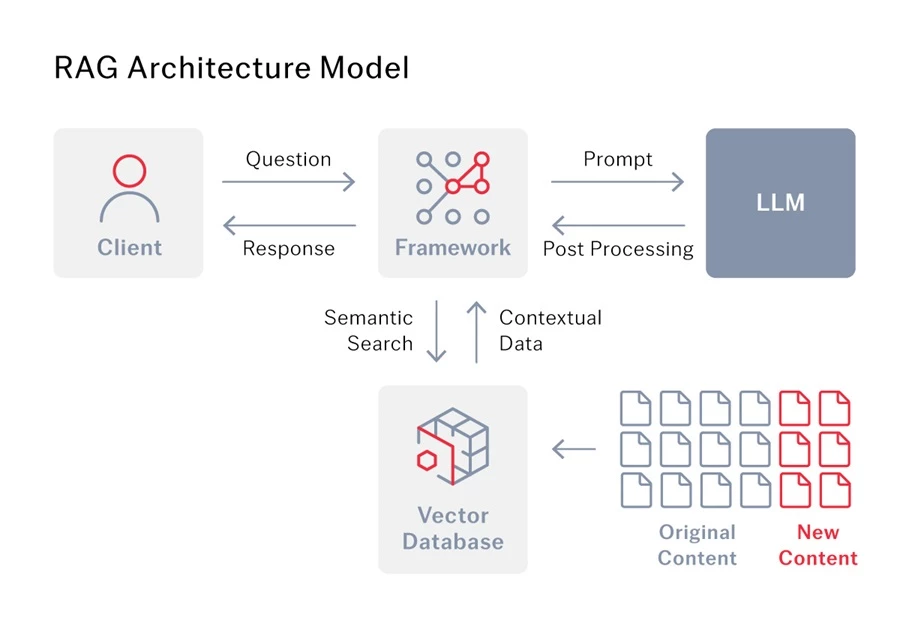

Qu'est-ce que la génération augmentée de récupération (RAG) ?

La génération augmentée de récupération (RAG) est une méthode d'IA de pointe qui permet aux modèles de langage de fournir de meilleures réponses. Habituellement, les modèles de langage ne s’appuient que sur les informations avec lesquelles ils ont été entraînés. Mais avec le RAG, le modèle peut aussi avoir accès à une base de connaissances ou de données distincte et peut exploiter ces informations supplémentaires pour générer des réponses plus précises.

RAG pour les LLM

Les LLM sont excellents pour générer du texte, mais leurs connaissances peuvent devenir obsolètes. La génération augmentée de récupération (RAG) résout ce problème en reliant les LLM à des sources d'information externes, comme Internet ou des bases de données spécialisées, si bien qu’ils peuvent toujours accéder aux informations les plus récentes et les plus pertinentes pour répondre à vos questions.

Mais le RAG ne se contente pas d'améliorer la précision. En combinant les informations obtenues avec le contexte de votre question, il aide le LLM à mieux comprendre vos besoins. Cela permet d'obtenir des réponses plus nuancées et plus pertinentes, et cela réduit les risques d'hallucinations. La qualité des données est essentielle, car elle fournit au LLM le contexte plus approfondi nécessaire à la génération de réponses vraiment pertinentes.

Prenons l'exemple du traitement intelligent des documents (IDP). Lorsqu'une entreprise utilise l'IDP parallèlement à un LLM, le RAG fait le lien entre les deux. Concrètement, le RAG permet au LLM d'accéder aux données extraites par l'IDP et de les exploiter. Le LLM dispose ainsi des données nécessaires pour fournir des résultats plus précis.

Choisir le modèle de langage adapté à vos besoins

Le modèle de langage adapté dépend de l'usage que vous souhaitez en faire. Les LLM sont parfaits pour les tâches exigeant une compréhension contextuelle approfondie, tandis que les SLM sont plus adaptés aux tâches spécifiques et ciblées et sont souvent intégrés à des plateformes plus vastes pour gérer efficacement des fonctions spécialisées.

D'ailleurs, vous utilisez peut-être déjà des SLM dans les outils que vous utilisez. La plateforme IDP d'ABBYY, par exemple, exploite les SLM pour des tâches comme l'OCR, ainsi que d'autres technologies d'IA comme l'apprentissage automatique (machine learning) et la segmentation sémantique des images. Ces outils s’associent pour automatiser les processus et améliorer la précision, optimisant ainsi l'efficacité de vos flux de travail.

Combiner les LLM et les SLM

Ashling, entreprise primée de services d'automatisation intelligente, cherchait une solution pour aider son client à extraire plus de 350 champs tirés de documents de location, dont la qualité, le type, le format et la langue variaient de l’un à l’autre. Pour relever ce défi, Ashling a testé plusieurs combinaisons de technologies selon cinq approches différentes et a retenu celle qui, de loin, a donné les meilleurs résultats : les LLM et les SLM, sous la forme d'ABBYY Vantage et de GPT-4 Turbo, ainsi que la RPA (automatisation robotisée des processus) Blue Prism.

Ensemble, GPT4 et ABBYY Vantage ont créé une expérience utilisateur consolidée, fournissant des résultats avant même toute formation spécifique sur le terrain. Cette approche utilise au mieux l'IDP pour la classification et la segmentation, et GenAI pour l'extraction des champs. Le fait d’associer l'IA générative, l'IDP et la RPA pour automatiser l'extraction et la saisie des données a permis d'atteindre un taux de précision de 82%. Pour le petit sous-ensemble de champs restant hors du seuil de confiance configuré, la station de révision manuelle d'ABBYY Vantage est utilisée ; elle permet à des humains de corriger les valeurs extraites par la machine. Le modèle d'apprentissage automatique (machine learning) apprend des valeurs corrigées manuellement et s'améliore au fil du temps, réduisant ainsi les besoins de révision manuelle. Vous pouvez consulter l’intégralité de l'étude de cas d'Ashling ici.

Tout est une question de qualité des données

En fin de compte, c’est la qualité des données dont vous alimentez le modèle de langage utilisé, quel qu’il soit, qui détermine la précision et la fiabilité des résultats. Pour relier efficacement vos données au modèle linguistique choisi, le RAG est essentiel. La génération augmentée par récupération d'ABBYY fonctionne en parfaite harmonie avec les modèles linguistiques pour fournir des réponses précises, contextuelles et à jour. En s'intégrant à votre base de connaissances existante, le RAG d'ABBYY garantit que votre IA dispose du contexte nécessaire pour générer des réponses intelligentes et fiables.

Contactez l'un de nos experts pour découvrir comment ABBYY peut améliorer la rapidité, la pertinence et l'adaptation des réponses de votre modèle de langage à votre activité.