La inteligencia artificial (IA) se ha convertido rápidamente en una necesidad competitiva en el entorno empresarial actual. En el corazón de muchas soluciones basadas en la IA, residen los modelos de lenguaje, potentes herramientas capaces de procesar y generar texto similar al creado por personas. Estas tecnologías están transformando la forma en que las empresas gestionan los documentos, los datos y la toma de decisiones.

Sin embargo, el éxito de cualquier aplicación de IA depende de un factor crítico: la calidad de los datos. Sin datos precisos y bien estructurados, los modelos de lenguaje más sofisticados también pueden fallar. En esta guía desglosaremos la diferencia entre los modelos de lenguaje grandes (LLM) y los modelos de lenguaje pequeños (SLM, ambos por sus siglas en inglés) y analizaremos por qué elegir el modelo adecuado, combinado con datos de alta calidad, es clave para aprovechar todo el potencial de la IA para su negocio.

Ir a:

¿Qué es un modelo de lenguaje?

¿Qué es un modelo de lenguaje pequeño?

Ventajas de los modelos de lenguaje pequeños

Ejemplo de modelo de lenguaje pequeño

¿Qué es un modelo de lenguaje grande?

Ventajas de los modelos de lenguaje grandes

Ejemplo de modelo de lenguaje grande

Modelos de lenguaje pequeños vs grandes: ¿cuáles son las diferencias?

¿Qué es un modelo de lenguaje?

Un modelo de lenguaje es un tipo de IA desarrollado para comprender, crear y predecir el lenguaje humano. Básicamente, un modelo de lenguaje aprende cuando se introducen grandes cantidades de texto, a partir del cual capta la gramática, los patrones y el contexto de palabras y frases. A continuación, el modelo utiliza esos conocimientos para escribir frases y párrafos, responder a preguntas, traducir idiomas, etc.

¿Qué es un modelo de lenguaje pequeño?

Un modelo de lenguaje pequeño (SLM) es, como se puede deducir por su nombre, un modelo de lenguaje que opera a menor escala. Estas herramientas de IA están diseñadas para centrarse en las tareas específicas para las que han sido concebidas y para ser eficientes.

Los SLM suelen ser más rápidos, más asequibles y más fáciles de entrenar, lo que los hace ideales para tareas específicas y concretas. En aplicaciones como el procesamiento inteligente de documentos (IDP, por sus siglas en inglés), los SLM pueden crearse específicamente para controlar funciones esenciales como la extracción de datos de documentos, la clasificación de documentos, el reconocimiento óptico de caracteres (OCR, por sus siglas en inglés) y el procesamiento del lenguaje natural (PLN). Los SLM pueden extraer con precisión información de una amplia gama de tipos de documentos, al tiempo que consumen menos potencia informática y dejan una huella medioambiental menor.

¿Qué es un modelo de lenguaje grande?

Un modelo de lenguaje grande (LLM) es una IA con capacidad para comprender y generar lenguaje humano a un nivel impresionantemente alto para diversos fines. ¿Matices sutiles o patrones intrincados? Da igual; estos modelos pueden captar esos pequeños detalles y, a menudo, ofrecen respuestas creativas y detalladas.

Los LLM están preparados para realizar una amplísima gama de tareas. Un solo LLM, por ejemplo, podría utilizarse para redactar una factura en varios idiomas, o también para ayudar a redactar notas clínicas a profesionales sanitarios. Como los LLM se construyen con miles de millones de parámetros, necesitan más potencia de cálculo, pero son capaces de utilizar esa potencia para crear contenidos únicos, imitar conversaciones detalladas y mucho más.

Ventajas de los modelos de lenguaje pequeños

Mayor no siempre significa mejor. Los modelos de lenguaje pequeños (SLM) ofrecen bastantes ventajas que los convierten en la opción perfecta para determinados procesos empresariales. Veamos cinco ventajas clave por las que destacan estas herramientas compactas de IA:

Rendimiento rápido

Si necesita realizar tareas específicas en un abrir y cerrar de ojos, los SLM pueden ser su mejor opción. Estas herramientas aprenden a partir de un conjunto de datos más reducido y específico, directamente relacionado con las tareas que deben realizar. Esto hace que los SLM sean más fáciles de enseñar y más rápidos de manejar, con un menor impacto medioambiental.

Por ejemplo, los SLM suelen utilizarse en IDP para identificar, clasificar y extraer datos de forma rápida y precisa de los documentos que llegan a una empresa. Otros usos de los SLM son los chatbots, que proporcionan un servicio instantáneo de atención al cliente, y los servicios de traducción en tiempo real, que mantienen la fluidez de las conversaciones, por citar solamente dos.

Presupuesto asequible

Las herramientas de IA no siempre requieren grandes recursos económicos. Por ejemplo, resulta más rentable crear SLM que modelos de mayor tamaño y su gestión es más asequible. Incluso las empresas de nueva creación autofinanciadas también tienen la oportunidad de aprovechar el poder de la IA sin un precio elevado.

Adaptado a organizaciones específicas

Cada organización tiene necesidades diferentes y los SLM pueden diseñarse específicamente para satisfacerlas, tanto si tienen que ver con formularios legales como con citas sanitarias. Se puede instruir a estos modelos con la información concreta de su empresa para que se conviertan en expertos en su nicho. No hay una solución única para todos.

Precisión

Cuando se necesitan resultados precisos y fiables, los SLM suelen ser la mejor opción. Como a los SLM se les enseñan tareas concretas, pueden ser más precisos que modelos mucho mayores y con un tiempo de procesamiento infinitamente menor. Los SLM pueden entender el contexto de preguntas con matices y generar respuestas únicas que sean pertinentes y significativas dentro de sus áreas de especialización. De hecho, cada vez son más las empresas que optan por los SLM en lugar de por modelos mayores y más generales para dar respuesta a sus necesidades concretas.

Fácil de actualizar

Las empresas tienen que adaptarse constantemente a los nuevos tiempos, por lo que sus herramientas de IA deben ser capaces de adaptarse a esos cambios. Los SLM son más fáciles de desarrollar y actualizar, lo que se traduce en que es más fácil mantenerlos al día con la información más reciente y las tendencias del sector. Su modelo puede seguir siendo pertinente y continuar ofreciendo información valiosa, también a medida que su empresa evoluciona.

Ventajas de los modelos de lenguaje grandes

Entrenados con cantidades ingentes de datos, los modelos de lenguaje grandes (LLM) pueden generar textos creativos, responder a preguntas complejas y comprender contextos y matices. Sin embargo, los LLM también pueden «alucinar» en ocasiones y generar información que parece verosímil, pero que es incorrecta o carece de sentido. A pesar de esta limitación, los beneficios potenciales de los LLM pueden convertirlos en una poderosa herramienta tanto para empresas como para particulares.

Amplia base de conocimientos

Los LLM han aprendido de una gran cantidad de información, por lo que tienen un amplio conocimiento del lenguaje y del mundo. Estos modelos pueden responder a una amplia gama de preguntas, resumir muchos tipos de información y también idear contenidos creativos con notable precisión.

Adaptabilidad y flexibilidad

Los LLM son increíblemente versátiles. Los LLM de código abierto y de uso general, como ChatGPT y Gemini, que se encuentran entre los más conocidos, pueden adaptarse y preentrenarse para fines empresariales especializados. Por ejemplo, los LLM pueden ajustarse para extraer información de documentos o ayudar a las empresas a mantenerse al día de los cambios en la normativa gubernamental. Asimismo, las empresas también pueden personalizar los LLM para que realicen una amplia gama de operaciones específicas del sector.

Capacidad multilingüe

Muchos LLM pueden comprender y generar texto en varios idiomas. Se trata de una función muy útil si su empresa está ubicada en varios países o trabaja con proveedores y clientes internacionales. Así, la comunicación y la colaboración transfronterizas son más fáciles.

Síntesis de conocimientos

Los LLM son expertos en manejar y dar sentido a grandes cantidades de información, lo que resulta útil cuando se trata de tareas que requieren una comprensión profunda y un análisis detallado. Por ejemplo, los LLM pueden revisar miles de documentos jurídicos y resumir los puntos clave, de modo que los abogados pueden obtener una visión de conjunto sin tener que leer todos y cada uno de los documentos en su totalidad. Esta capacidad para reunir y relacionar información compleja hace que los LLM sean útiles para la realizar investigaciones profundas.

Aumento de la creatividad

Los LLM son muy hábiles a la hora de generar contenidos profesionales debido a su amplia formación en datos lingüísticos diversos y exhaustivos, incluyendo la terminología y los estilos de comunicación específicos de cada sector. Sin embargo, disponer de buenos datos sobre los que trabajar es clave para obtener buenos resultados de un LLM, sobre todo en un entorno profesional. Con el acceso a los datos adecuados y la generación aumentada por recuperación (RAG, por sus siglas en inglés) para conectar los LLM con fuentes de conocimiento externas, un LLM puede redactar textos de marketing convincentes, generar informes detallados o incluso producir respuestas de correo electrónico personalizadas, todo ello manteniendo una voz de marca coherente. Sus avanzadas capacidades lingüísticas les permiten producir resultados persuasivos e informativos, lo que las convierte en valiosas herramientas para la comunicación empresarial y la creación de contenidos.

Modelos de lenguaje pequeños vs grandes: ¿cuáles son las diferencias?

Tamaño y complejidad

Los modelos de lenguaje grandes (LLM) contienen una cantidad de conocimientos mucho mayor que los modelos de lenguaje pequeños (SLM). Ello se debe a que los LLM tienen un gran número de parámetros (a menudo cientos de millones), lo que los hace muy avanzados y capaces de gestionar un amplio espectro de tareas.

Sin embargo, los LLM también pueden ser lentos y consumir muchos recursos, ya que tardan hasta cincuenta veces más en procesar la información que los modelos más pequeños. En cambio, los SLM están diseñados para ser más ágiles, con un número de parámetros de entre un millón y diez millones. Este diseño hace que los SLM sean más rápidos y eficaces a la hora de entrenarlos y usarlos.

Costes y recursos necesarios

Los SLM funcionan como coches compactos eficientes, mientras que los LLM lo hacen más como camiones grandes. Dado que los LLM requieren mucha más potencia de cálculo y memoria, su ejecución puede resultar bastante cara. Los LLM también pueden tener un impacto ambiental considerable debido a su elevado consumo de energía. En cambio, los SLM son más ligeros, consumen menos energía y suelen funcionar con hardware estándar.

Capacidades

Los LLM destacan en un amplio abanico de tareas y ofrecen resultados precisos y fluidos. En cambio, los SLM están especializados en aplicaciones concretas, lo que les permite rendir bien utilizando menos recursos y con menos costes.

Por ejemplo, un modelo de lenguaje pequeño adaptado a las cuentas por pagar puede centrarse en la información exacta que su equipo de cuentas por pagar necesita y omitir todos los demás datos irrelevantes. Este enfoque específico no solo acelera el procesamiento, sino que a menudo ofrece una precisión comparable a la de modelos mucho más grandes, al tiempo que consume menos recursos.

Los SLM y los LLM: ejemplos

Ejemplo de modelo de lenguaje pequeño

Los SLM están transformando las industrias con sus conocimientos específicos y su eficiencia. Un SLM adaptado al procesamiento inteligente de documentos (IDP), por ejemplo, puede mejorar el reconocimiento óptico de caracteres (OCR) en el tratamiento de documentos. Esto, además de disminuir el tiempo que requiere el flujo de trabajo, también reduce los errores en comparación con los métodos manuales.

Ejemplo de modelo de lenguaje grande

Los LLM son la fuerza motriz de herramientas de IA tan populares como ChatGPT, capaces de gestionar una amplia gama de tareas, desde la lluvia de ideas para campañas publicitarias hasta la traducción de formularios. Dicho esto, los LLM también se pueden ajustar si se entrenan con miles de millones de parámetros directamente relacionados con una tarea específica. Por ejemplo, en el campo de la medicina, un LLM podría ajustarse usando un vasto conjunto de datos de literatura médica y registros de pacientes para convertirse en especialista a la hora de responder consultas médicas complejas.

Los SLM y los LLM a partir de RAG

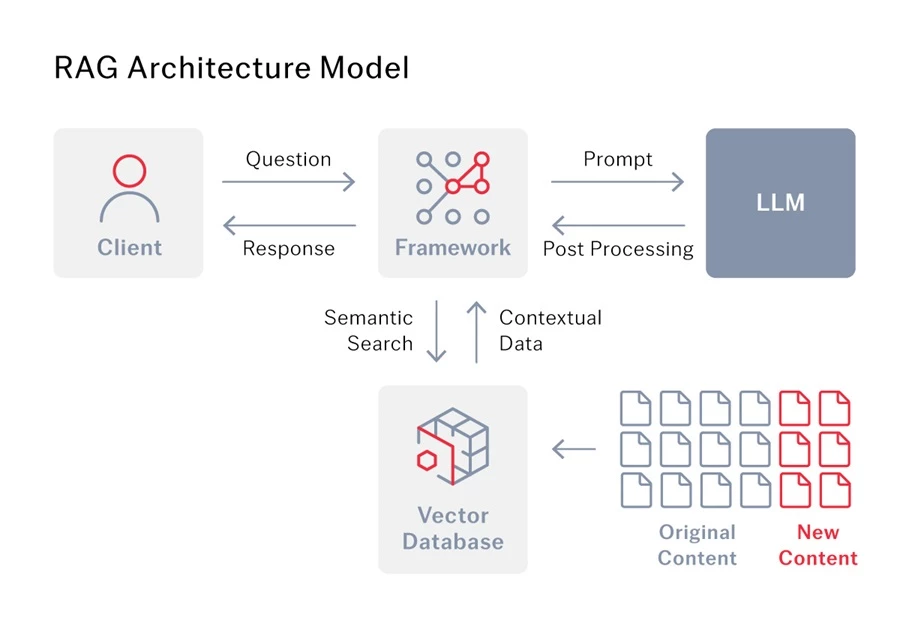

¿Qué es la generación aumentada por recuperación (RAG)?

La generación aumentada por recuperación (RAG) es un método avanzado de IA que permite a los modelos de lenguaje dar mejores respuestas. Por lo general, los modelos de lenguaje tienen que basarse únicamente en la información con la que han sido entrenados. Sin embargo, con la RAG, el modelo también tiene acceso a una base de conocimientos o base de datos independiente y puede utilizar esa información adicional para generar respuestas más precisas.

RAG para LLM

Los LLM son estupendos generando textos, pero sus conocimientos pueden quedar desfasados. La generación aumentada por recuperación (RAG) resuelve este problema vinculando los LLM a fuentes externas de información, como internet o bases de datos especializadas, de modo que siempre puedan acceder a los datos más recientes y pertinentes para responder a sus preguntas.

Sin embargo, la generación aumentada por recuperación no solo mejora la precisión. Al combinar la información que encuentra con el contexto de su pregunta, la generación aumentada por recuperación ayuda al LLM a comprender mejor sus necesidades. De este modo, se obtienen respuestas más matizadas y pertinentes, lo que reduce la posibilidad de alucinaciones. En este caso, es fundamental contar con datos de alta calidad, ya que proporcionan al LLM el contexto más profundo que necesita para generar respuestas verdaderamente detalladas.

Tomemos como ejemplo el procesamiento inteligente de documentos (IDP). Cuando una empresa utiliza el procesamiento inteligente de documentos junto con un LLM, la generación aumentada por recuperación actúa como conector entre ambos. Básicamente, esta última permite al LLM acceder a los datos extraídos por el procesamiento inteligente de documentos y utilizarlos, lo que le proporciona los datos necesarios para ofrecer resultados más precisos.

Elegir el modelo de lenguaje adecuado a sus necesidades

El modelo de lenguaje adecuado depende de para qué se quiera utilizar. Los LLM son ideales para tareas que requieren grandes cantidades de comprensión contextual, pero los SLM son más adecuados para tareas concretas y específicas, y a menudo se integran en plataformas más grandes para llevar a cabo funciones especializadas de manera eficiente.

De hecho, es posible que ya esté utilizando SLM en las herramientas en las que confía. La plataforma de IDP de ABBYY, por ejemplo, aprovecha los SLM para tareas como el OCR, junto con otras tecnologías de inteligencia artificial como el aprendizaje automático y la segmentación semántica de imágenes. Estas herramientas trabajan juntas para ayudar a automatizar los procesos y mejorar la precisión, haciendo que sus flujos de trabajo sean más eficientes.

Combinación de LLM y SLM

Ashling, una galardonada empresa de servicios de automatización inteligente, necesitaba una solución que ayudara a un cliente a extraer más de trescientos cincuenta campos de documentos relacionados con arrendamientos, que llegaban con diferentes condiciones de calidad, tipos de documentos, formatos e idiomas. Para resolver este reto, Ashling probó varias combinaciones tecnológicas aplicando cinco enfoques diferentes y se decantó por la combinación que ofrecía un resultado muy superior: modelos de lenguaje grandes y pequeños, a través de ABBYY Vantage y GPT-4 Turbo, junto con la automatización robótica de procesos Blue Prism.

Juntos, GPT-4 y ABBYY Vantage crearon una experiencia de usuario consolidada, proporcionando resultados antes de cualquier entrenamiento a nivel de campos. Este enfoque aprovecha el procesamiento inteligente de documentos para la clasificación y segmentación y la IA generativa para la extracción de campos. La integración de IA generativa, procesamiento inteligente de documentos y automatización robótica de procesos para automatizar la extracción e introducción de datos logró una tasa de precisión del 82 %. Para el pequeño subconjunto de campos que quedan fuera del umbral de confianza configurado, se utiliza la estación de revisión manual de ABBYY Vantage para que los usuarios puedan corregir los valores extraídos por la máquina. El modelo de aprendizaje automático aprende de los valores corregidos por los humanos y mejora con el tiempo, lo que reduce las necesidades de revisión manual. Lea aquí el estudio de caso completo de Ashling.

Todo gira en torno a la calidad de los datos

En última instancia, la calidad de los datos que se introducen en cualquier modelo de lenguaje que se utilice determina la precisión y fiabilidad de los resultados. Para conectar eficazmente sus datos con el modelo de lenguaje que elija, la RAG es esencial. La generación aumentada por recuperación (RAG) de ABBYY funciona a la perfección con modelos de lenguaje para proporcionar respuestas precisas, contextuales y actualizadas. Al integrarse con su base de conocimientos existente, la generación aumentada por recuperación de ABBYY garantiza que su IA disponga del contexto necesario para generar respuestas inteligentes y fiables.

Póngase en contacto con uno de nuestros expertos para saber cómo ABBYY puede hacer que las respuestas de su modelo de lenguaje sean más oportunas, pertinentes y adaptadas a su empresa.